Первый крупный теннисный сезон сезона начнется в эти выходные с Открытого чемпионата Австралии по теннису, в котором примут участие действующие чемпионы среди мужчин и женщин Янник Синнер и Арина Соболенко, а также фавориты болельщиков национального рейтинга Карлос Алькарас, Новак Джокович, Тейлор Фриц, Коко Гауфф, Николас Жарри. , Даниил Медведев, Наоми Осака, Джессика Пегула, Бен Шелтон, Ига Святек и более. Открытый чемпионат Австралии 2025 Как слушать SiriusXM каждый вечер в 19:00 по восточному времени доставит вас в Мельбурн для прямой трансляции Открытого чемпионата Австралии по теннису. Номера каналов Предварительный просмотр Приготовьтесь к первому турниру Большого шлема 2025 года с Трейси Остином и Дэном Гракой, которые проведут ежегодное предварительное шоу Открытого чемпионата Австралии по теннису, которое уже сейчас можно транслировать в приложении SiriusXM. Расписание турниров в одиночном разряде 11–14 января: Первый тур15–16 января: Второй тур17–18 января: Третий раунд19–20 января: Четвертый раунд21–22 января: четвертьфиналы23 января: женские полуфиналы24 января: полуфиналы среди мужчин25 января: женский финал26 января: мужской финал

добавил

Ева Бергеp

238

Открытый чемпионат Австралии по теннису 2025: слушайте прямую радиотрансляцию каждого раунда из Мельбурна

195

0 коммент | + добавить

добавил

Beata Undine

148

10 этических проблем в разработке ИИ и способы их решения

Искусственный интеллект (ИИ) стал преобразующей силой во всех отраслях, повышая эффективность, улучшая процесс принятия решений и открывая новые возможности. Однако быстрое развитие ИИ также создает серьезные этические проблемы, которые разработчики, предприятия и политики должны решить, чтобы технологии приносили пользу человечеству на справедливой и ответственной основе. В этом сообщении блога рассматриваются десять ключевых этических проблем в разработке ИИ и предлагаются стратегии их эффективного решения.1. Предвзятость в моделях ИИМодели ИИ часто обучаются на исторических данных, которые могут отражать социальные предубеждения, приводящие к несправедливым или дискриминационным результатам. Например, предвзятые алгоритмы найма могут отдавать предпочтение определенным демографическим группам, исключая при этом другие, закрепляя существующее неравенство и маргинализируя недостаточно представленные группы. Эта проблема подрывает доверие и вызывает юридические и этические проблемы, особенно в таких областях, как набор персонала, кредитный скоринг и правоохранительная деятельность.Как решить эту проблему: Обеспечьте разнообразие наборов данных: Собирайте и используйте наборы данных, репрезентативные для различных демографических групп, обеспечивая инклюзивность данных. Регулярный аудит: Периодически проверяйте системы искусственного интеллекта на наличие предвзятых результатов, используя показатели справедливости, чтобы выявлять и смягчать неравенство. Междисциплинарные команды: Привлекайте специалистов по этике, социологов и экспертов в предметной области к разработке ИИ, чтобы выявить потенциальные предубеждения и устранить их на раннем этапе. Алгоритмы, учитывающие справедливость: Внедрить такие методы, как повторное взвешивание или повторная выборка данных, и использовать алгоритмы, специально разработанные для уменьшения систематической ошибки. Взаимодействие с заинтересованными сторонами: Сотрудничать с затронутыми сообществами, чтобы понять их потребности и проблемы, обеспечивая справедливость и выгодность систем. 2. Отсутствие прозрачности (модели черного ящика)Многие модели искусственного интеллекта, особенно системы глубокого обучения, работают как «черные ящики», а это означает, что их внутренняя работа непрозрачна даже для их разработчиков. Отсутствие прозрачности затрудняет доверие к системам искусственного интеллекта, особенно в таких важных сценариях, как медицинские диагнозы или судебные решения.Как решить эту проблему: Объяснимый ИИ (XAI): Используйте инструменты и методы, которые делают решения ИИ интерпретируемыми, такие как SHAP (аддитивные объяснения Шепли) или LIME (локальные интерпретируемые модельно-агностические объяснения). Четкая документация: Предоставьте подробную документацию процесса принятия решений ИИ, включая архитектуру модели, данные обучения и показатели оценки. Многоуровневая прозрачность: адаптируйте объяснения для разных аудиторий — технические подробности для разработчиков и упрощенные сведения для конечных пользователей. Мандаты прозрачности: Установите правила, требующие от разработчиков раскрывать процессы рассуждения ИИ, особенно в таких важных приложениях, как найм, кредит или здравоохранение. Аудируемые системы: Создайте системы искусственного интеллекта, которые позволят независимым сторонним аудиторам оценивать их справедливость, точность и надежность. 3. Проблемы конфиденциальности данныхСистемы искусственного интеллекта часто полагаются на огромные объемы персональных данных, что вызывает серьезные опасения по поводу утечки данных, неправильного использования и нарушения конфиденциальности личности. Неэтичное использование персональных данных может привести к краже личных данных, несанкционированному наблюдению и потере доверия пользователей.Как решить эту проблему: Минимизация данных: Собирайте только те данные, которые необходимы для конкретного приложения, что снижает риски для конфиденциальности. Анонимизация и шифрование: применять такие методы, как анонимизация личных данных и шифрование конфиденциальной информации, для защиты пользовательских данных. Соответствие нормативным требованиям: соответствие законам о защите данных, таким как GDPR (Общие правила защиты данных) и CCPA (Закон Калифорнии о конфиденциальности потребителей), обеспечивая согласие пользователей и контроль над их данными. Методы сохранения конфиденциальности: использовать такие методы, как федеративное обучение, которое позволяет моделям ИИ обучаться на децентрализованных данных без совместного использования необработанных данных, а также дифференциальную конфиденциальность для добавления шума в наборы данных, защищая индивидуальную информацию. Расширение прав и возможностей пользователей: предоставить пользователям четкие возможности выбора или отказа от сбора данных и объяснить, как их данные будут использоваться. 4. Подотчетность и ответственностьКогда системы ИИ выходят из строя или причиняют вред (например, ставят неверный диагноз пациентам или дают неправильные финансовые рекомендации), часто неясно, кто несет ответственность: разработчик, организация, внедряющая ИИ, или сам ИИ. Отсутствие подотчетности может подорвать доверие и задержать внедрение ИИ.Как решить эту проблему: Системы подотчетности: Четко определить роли и обязанности разработчиков, развертывателей и пользователей систем искусственного интеллекта для установления подотчетности. Оценка рисков: Провести тщательную оценку потенциальных рисков и задокументировать стратегии их смягчения перед развертыванием. Политика управления ИИ: Внедрить политику, определяющую, кто несет ответственность за ущерб, причиненный системами искусственного интеллекта, обеспечивая юридическую ясность. Мониторинг и отчетность: постоянно отслеживать производительность ИИ и создавать каналы, по которым пользователи могут сообщать о проблемах или непредвиденных последствиях. Этические стандарты: Разработать и соблюдать общеотраслевые этические стандарты развертывания и использования ИИ. 5. Смещение рабочих мест и экономическое неравенствоАвтоматизация ИИ может вытеснить миллионы работников, особенно в таких отраслях, как производство, транспорт и обслуживание клиентов. Это может расширить экономическое неравенство, особенно среди низкоквалифицированных работников, и вызвать социальные волнения.Как решить эту проблему: Программы переподготовки: Инвестируйте в программы обучения, которые помогут работникам приобрести навыки для новых должностей, созданных с помощью ИИ и автоматизации. Государственно-частное партнерство: Сотрудничать с правительствами и образовательными учреждениями для создания путей перехода уволенных работников на новую работу. Редизайн вакансии: Определите области, в которых люди могут дополнять ИИ, уделяя особое внимание ролям, требующим творчества, сочувствия и решения проблем. Стратегии инклюзивного роста: Поощряйте предприятия уделять приоритетное внимание благополучию сотрудников, сочетая автоматизацию с сохранением рабочих мест. Системы социальной защиты: Выступайте за такие меры, как всеобщий базовый доход или пособия по безработице, для поддержки уволенных работников. 6. Вооружение ИИТехнологии искусственного интеллекта, такие как автономное оружие и передовые системы наблюдения, могут использоваться в злонамеренных целях, включая ведение войны, угнетение и терроризм. Бесконтрольное распространение ИИ в военных целях создает этические и экзистенциальные риски.Как решить эту проблему: Международные правила: Выступайте за глобальные договоры и соглашения, запрещающие использование автономного смертоносного оружия и устанавливающие этические принципы для военного ИИ. Надзор за двойным назначением: Внедрить строгий экспортный контроль и лицензионные требования для технологий искусственного интеллекта с потенциалом двойного использования. Этические принципы дизайна: Требовать от разработчиков включения мер безопасности, предотвращающих неправильное использование технологий искусственного интеллекта. Сотрудничество: Взаимодействовать с политиками, некоммерческими и международными организациями для создания надежных механизмов надзора. Общественная осведомленность: Информировать общественность о рисках использования ИИ в качестве оружия, чтобы способствовать информированному обсуждению и подотчетности. 7. Культурное и социальное воздействиеСистемы искусственного интеллекта, разработанные без учета местного контекста, могут непреднамеренно разрушать культурную самобытность, способствовать гомогенизации или усиливать социальные различия. Например, языковые модели могут маргинализировать языки меньшинств, одновременно продвигая доминирующие.Как решить эту проблему: Участие местных заинтересованных сторон: Взаимодействуйте с лидерами сообщества и местными экспертами, чтобы гарантировать, что решения ИИ соответствуют культурным нормам и ценностям. Культурно-чувствительный дизайн: Разрабатывать системы искусственного интеллекта, учитывающие различные языки, традиции и обычаи. Инклюзивные команды: Создавайте разнообразные команды разработчиков, чтобы учитывать широкий спектр точек зрения. Модерация контента: Разработайте алгоритмы, которые избегают усиления вызывающего разногласия или культурно нечувствительного контента. Образовательная деятельность: Содействие осведомленности и пониманию культурного воздействия на исследования и разработки в области ИИ. 8. Воздействие на окружающую средуОбучение и внедрение моделей искусственного интеллекта, особенно крупных, таких как GPT-3, требуют значительных вычислительных ресурсов, что вносит значительный вклад в выбросы углекислого газа и деградацию окружающей среды.Как решить эту проблему: Энергоэффективные алгоритмы: Оптимизируйте модели ИИ, чтобы снизить их вычислительные и энергетические требования. Зеленые дата-центры: Переход к использованию возобновляемых источников энергии для дата-центров, питающих системы искусственного интеллекта. Оценка жизненного цикла: Оцените воздействие систем искусственного интеллекта на окружающую среду на протяжении всего их жизненного цикла, от разработки до внедрения. Программы компенсации выбросов углерода: Инвестируйте в лесовосстановление и другие инициативы по устойчивому развитию, чтобы компенсировать выбросы углерода. Информационные кампании: Поощрять исследовательское сообщество в области искусственного интеллекта уделять приоритетное внимание устойчивости при разработке моделей. 9. Манипуляции и дезинформацияИнструменты на базе искусственного интеллекта могут генерировать весьма убедительный фейковый контент, такой как дипфейки и сфабрикованные новости, который можно использовать для манипулирования общественным мнением, срыва выборов или подстрекательства к насилию.Как решить эту проблему: Инструменты обнаружения: Разработка усовершенствованных алгоритмов для выявления и маркировки дезинформации и дипфейков, созданных искусственным интеллектом. Системы проверки: Сотрудничать с платформами социальных сетей для внедрения значков проверки и механизмов проверки фактов для онлайн-контента. Медиаграмотность: Обучите общественность распознавать и критически оценивать контент, созданный искусственным интеллектом. Политика модерации контента: Работать с политиками над регулированием распространения фейкового контента, сохраняя при этом свободу слова. Исследовательские инициативы: Поддерживать исследования по борьбе с дезинформацией и ее социальными последствиями. 10. Этическое принятие решений в ИИСистемы искусственного интеллекта могут столкнуться с моральными дилеммами, такими как решение о том, как расставить приоритеты в отношении жизней в результате аварий с участием беспилотных транспортных средств или распределение ограниченных медицинских ресурсов. Эти проблемы требуют внедрения этических принципов в процессы принятия решений с помощью ИИ.Как решить эту проблему: Этические рамки: Включите устоявшиеся моральные философии, такие как утилитаризм или деонтология, в системы искусственного интеллекта, чтобы направлять процесс принятия решений. Общественные консультации: Вовлекайте сообщества в дискуссии об этических дилеммах для согласования ИИ. Этические рамки: Включите устоявшиеся моральные философии, такие как утилитаризм или деонтология, в системы искусственного интеллекта, чтобы направлять процесс принятия решений. Общественные консультации: Вовлекайте сообщества в дискуссии об этических дилеммах для согласования ИИ. Этические проблемы при разработке ИИ сложны, но не являются непреодолимыми. Отдавая приоритет справедливости, прозрачности, подотчетности и устойчивости, разработчики и организации могут создавать системы искусственного интеллекта, которые соответствуют общественным ценностям и способствуют всеобщему благу. Поскольку ИИ продолжает развиваться, постоянное сотрудничество между технологами, политиками, специалистами по этике и общественностью будет иметь решающее значение для ответственного решения этих проблем.

105

0 коммент | + добавить

добавил

Beata Undine

159

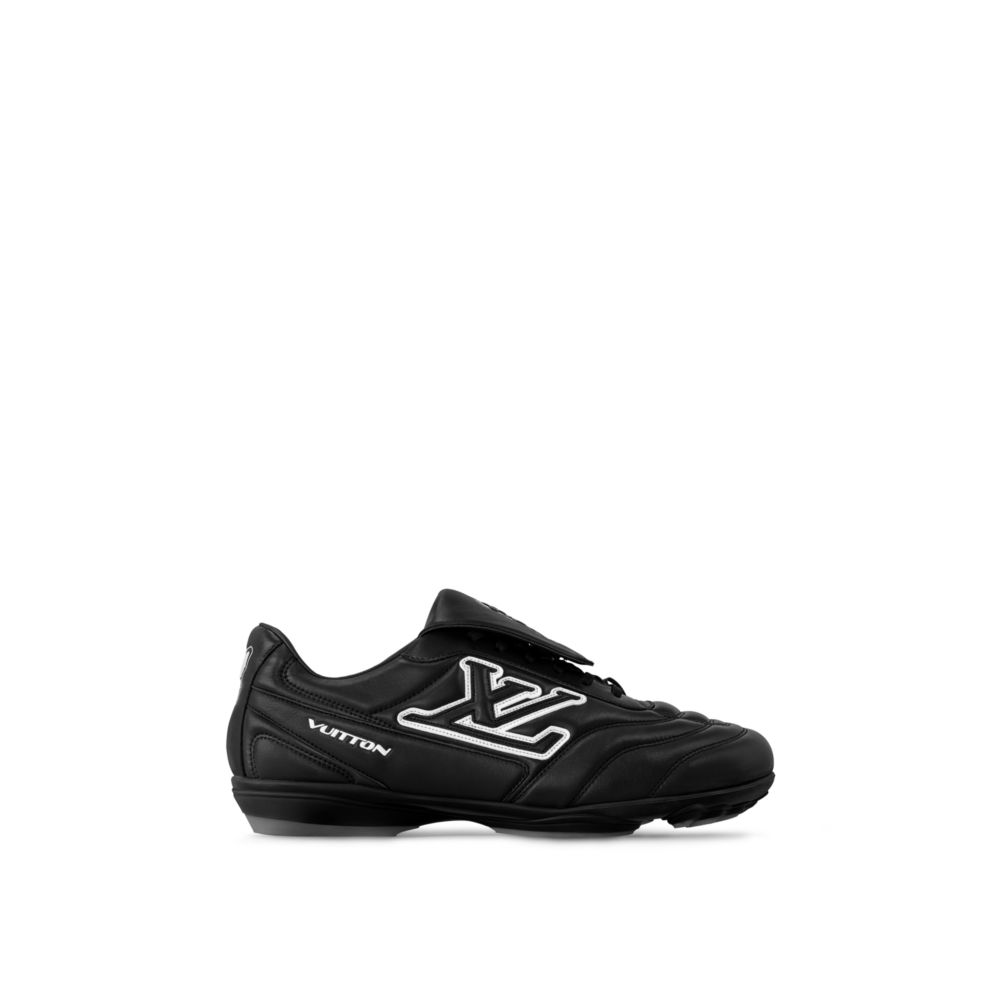

лв след футбол | Фаррелл открывает новую эру роскошного спорта

Мода всегда флиртовала со спортом, но дебют Фаррелла Уильямса в Louis Vuitton Футбол LV Footprint кроссовки выводят игру на неизведанную территорию. Этот изящный силуэт, впервые появившийся на мужском подиуме весна-лето 2025, представляет собой свежий взгляд на обувь с шипами, дополненную безошибочными подписями Vuitton и здоровой дозой игривого прикосновения Фаррелла. Поклонники давнего диалога Палаты представителей со спортом из баскетбольной книги Вирджила Абло. Кроссовки ЛВ к культовому любимцу Киполл Футболсразу почувствует преемственность мастерства, смелости и прихоти. Основанный на футбольной ностальгии, но при этом абсолютно современный, Футбол LV Footprint оставляет свой след — в буквальном смысле. Мягкая резиновая подошва украшена удлиненным логотипом LV и цветочным мотивом Monogram, оставляющим отпечаток пяти пальцев на мягкой земле — дерзкое напоминание о том, что даже роскошь оставляет следы. Эта тактильная деталь напоминает умение Vuitton сочетать повествование с ноу-хау, перекликаясь с игривой непочтительностью тисненых монограмм. Арочные светильники НН или футуристический дизайн Абло ЛВ Скейт. Верх, стеганый по наклонным линиям, вдохновленный аэродинамическими шипами, повышает спортивную точность благодаря мастерству обработки телячьей кожи. В довершение всего, откидной язычок, скрывающий шнурки с монограммой, украшен тиснением фирменного логотипа LVERS UNITED — отсылки к футбольным фанатам. Настоящие ценители обратят внимание на небольшую марку Vuitton, выполненную спортивным шрифтом, и дату «1854», вышитую на пятке — изящный намек на начало Дома. Именно такая тщательная детализация превращает изделия Vuitton в объекты одержимости. Цветовые решения смелые, монохромные и непримиримо крутые: черный, белый, красный, синий и лесной зеленый. Тональные принты и четкие белые акценты создают глубину, а подошва расширяет цвет обуви, создавая целостное скульптурное ощущение. Вспомните склонность Фаррелла к игривой яркости в сочетании с традицией точности Дома – это роскошь и уличная развязность. Для тех, кто следил за модными и спортивными кроссоверами Vuitton, от скейтбордов эпохи Мураками Марка Джейкобса до культовых футбольных коллабораций Кима Джонса, эта коллекция — момент для коллекционера, ожидающий возможности зашнуровать его. LV Footprint Soccer доступен для предварительного заказа на LV.com и в приложении LV с 26 декабря, а глобальный запуск в магазинах состоится 2 января. фотография. Луи Виттон слова. Дженнаро Костанцо Твитнуть

116

0 коммент | + добавить