Все причины, по которым ИИ не оправдал ажиотаж в 2025 году – и что будет дальше в 2026 году

Все причины, по которым ИИ не оправдал ажиотаж в 2025 году – и что будет дальше в 2026 году

СИНГАПУР – В ноябре The Straits Times обратилась к платформе по листингу недвижимости PropertyGuru, чтобы узнать о

растущая тенденция изображений, созданных с помощью искусственного интеллекта

в объявлениях о местной недвижимости после того, как некоторые пользователи сети выразили гнев по поводу изображений.

В ответ компания сообщила ST, что на платформе запрещено размещать «фотографии, полностью созданные искусственным интеллектом». Когда компания предоставила конкретные примеры использования таких фотографий без раскрытия информации, компания позже добавила, что любая виртуальная постановка или редактирование должны быть четко указаны.

«Наша команда связалась с задействованными агентами, чтобы принять корректирующие меры, где это необходимо», — сказал представитель компании. Изображения, созданные ИИ в приведенных примерах, были удалены.

Однако шесть недель спустя поиск по платформе выявил множество списков объектов недвижимости, в которых изображения, созданные ИИ, все еще используются без раскрытия информации — иногда вместо любых реальных фотографий реального рекламируемого жилого помещения.

Этот случай является символом многих внедрений искусственного интеллекта в Сингапуре в 2025 году: общественная полемика перерастает в коллективное пожимание плечами.

Если 2022 год был годом, когда в мире впервые разразилась мания ИИ, после публичного выпуска инструмента генеративного ИИ ChatGPT, то 2025 год стал годом, когда ИИ стал неизбежным.

Социальные сети Сингапура переполнены примерами пользователей сети, указывающих на странные и неестественные изображения, созданные искусственным интеллектом и используемые в маркетинговых кампаниях. Изображения, созданные с помощью искусственного интеллекта, больше не являются чем-то необычным на плакатах и вывесках в центральных кварталах.

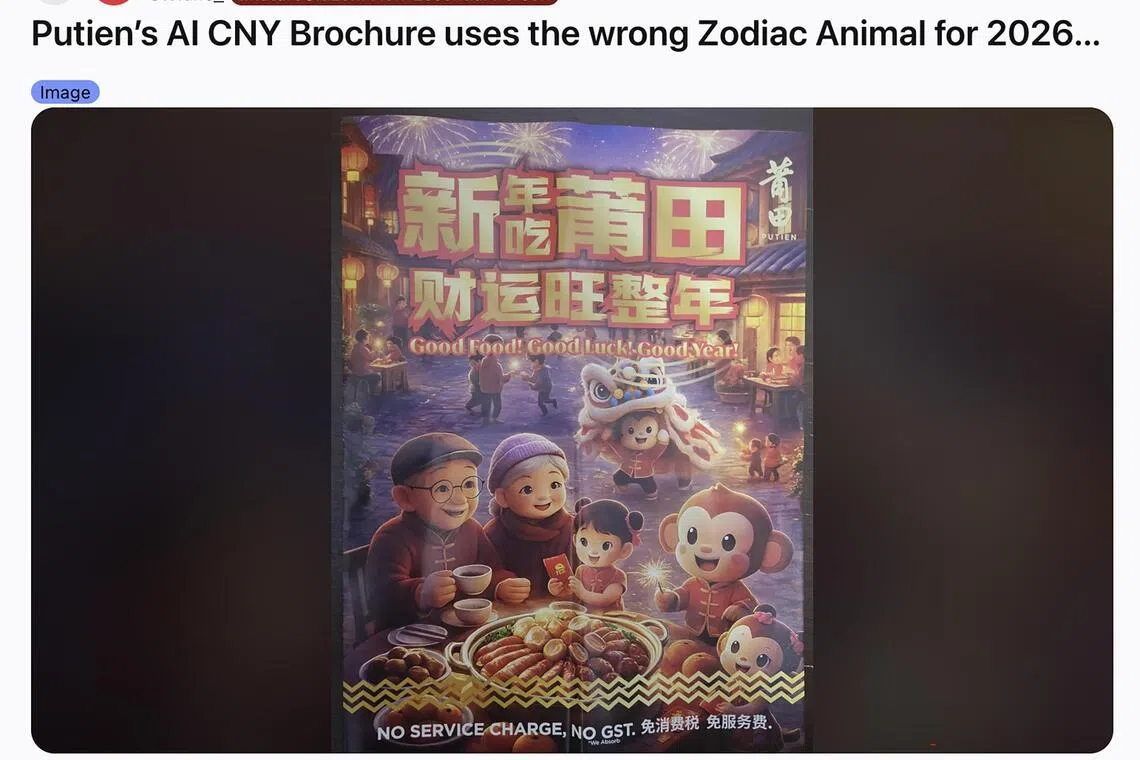

Совсем недавно пользователи Reddit высмеяли изображение, использованное в брошюре по китайскому Новому году местной сетью ресторанов Фуцзянь Putien, содержащее явные признаки использования ИИ.

Эксперты говорят, что темпы развития искусственного интеллекта — это палка о двух концах.

Пользователи Reddit указали на явные признаки использования ИИ в брошюре местной сети ресторанов, посвященной китайскому Новому году.

ФОТО: СКРИНГРАБЛ С REDDIT

Г-н Пун Кинг Ван, главный специалист по стратегии и дизайну в Сингапурском университете технологий и дизайна, говорит: «Это может превзойти человеческие возможности» не только сохранять темп и контроль, но и ускоряет человеческие способности и творческие способности».

Это означает, что одной из определяющих тенденций 2025 года стали разногласия по поводу того, когда и как следует использовать ИИ.

Наньянский технологический университет

оштрафовал троих студентов

по поводу использования ими инструментов искусственного интеллекта при написании эссе в июне, что вызвало бурю споров и комментариев в Интернете, когда студенты обратились в социальные сети, чтобы оспорить свою оценку. Некоторые признаки использования ИИ включали несуществующие научные ссылки.

Тем не менее, онлайн-дискуссия вскоре вышла за рамки этого первоначального случая и перешла к вопросу о том, что представляет собой неэтичное использование ИИ в образовании, когда генеративный ИИ был включен в поисковые системы и текстовые процессоры.

Кластер здравоохранения Национальная система университетского здравоохранения

внедряет периоды «без ИИ»

– в течение которого медицинским работникам следует избегать использования инструментов искусственного интеллекта для клинической работы или оценок – в 2025 году, чтобы избежать потери навыков из-за чрезмерной зависимости от технологий.

А в июле 2025 года специалисты в области психического здоровья сообщили ST, что они наблюдают рост числа пациентов, которые используют такие инструменты, как ChatGPT, в качестве доверенного лица. Эти специалисты предупреждают, что, хотя ChatGPT может время от времени давать полезные общие советы, он не может удовлетворить потребности людей с более сложными потребностями.

Хотя бы один случай

Психоз, вызванный ИИ

был замечен в Институте психического здоровья после того, как чат-бот пациента сказал ему, что его душа умрет, если он обратится в определенную веру.

Доктор Люк Сун, руководитель направления ИИ (цифровые решения) в PwC Сингапур, говорит, что одна из наиболее тревожных тенденций года заключается в том, что «ИИ стал внедрен в повседневные операции быстрее, чем многие организации полностью осознают его ограничения».

Многие организации внедряют ИИ-пилоты и инструменты автоматизации, не понимая, как ведут себя эти системы, как принимаются решения и где в конечном итоге находится подотчетность.

Он добавляет, что со временем то, как организации управляют использованием ИИ, должно постоянно меняться, а не оставаться статичным. «Смешанные сигналы, наблюдаемые сегодня, соответствуют переходу, который все еще происходит».

Термин «поле искажения реальности» первоначально использовался для описания способностей основателя Apple Стива Джобса. убедить других в том, что иначе невозможные цели достижимы — термин, который с тех пор используется для описания многих других технологических лидеров и стартапов.

2025 год показал, что ИИ тоже имеет свое собственное поле искажения реальности, и противоречивые доказательства его полезности не замедлили его принятие обществом.

Исследование, проведенное исследователями Массачусетского технологического института (MIT), опубликованное в июле 2025 года, показало, что 95 процентов из более чем 300 инициатив в области искусственного интеллекта в изученных компаниях не принесли прибыли.

«Смешанные результаты не являются неожиданными. Новые технологии внедряются быстрее, чем организации могут перепроектировать рабочие процессы и процесс принятия решений, чтобы полностью реализовать их влияние, и ИИ не является исключением», — говорит д-р Сун.

Доктор Кокил Джайдка, доцент кафедры коммуникаций и новых медиа Национального университета Сингапура, отмечает, что прирост производительности от ИИ неравномерен: «Мы видим реальные, измеримые улучшения в некоторых областях и гораздо меньшую отдачу в других».

ИИ явно повышает производительность при выполнении рутинных, модульных и легко поддающихся оценке задач. Например: сократить время, необходимое для выполнения определенных задач по программированию, написать фрагмент текста при работе в службе поддержки или выполнить сложные научные расчеты для прогнозирования новых последовательностей белков.

«Но эти преимущества быстро сходят на нет, когда задачи требуют суждения, контекстуального понимания или ответственности за результаты», — говорит доктор Кокил.

Во многих исследованиях опытные работники, использующие ИИ, выполняют работу быстрее, но не лучше, а иногда и хуже. Это потому, что они тратят время на проверку, исправление и компенсацию уверенных, но неправильных результатов, добавляет она.

Производительность часто меняется, а не увеличивается: меньше времени на создание, больше времени на контроль.

Несмотря на это, ИИ является часто упоминаемой причиной увольнений и реструктуризации, особенно в таких технологических гигантах, как Amazon и Meta. В феврале 2025 года сингапурский банк DBS объявил, что сократит 4000 временных и контрактных должностей на своих 19 рынках в течение следующих трех лет из-за внедрения ИИ.

Поскольку разговор все чаще заходит о переквалификации и опыте, связанном с искусственным интеллектом, эксперты также

выразил обеспокоенность по поводу его влияния на роли младшего уровня

– те, которые, скорее всего, будут автоматизированы с помощью технологии.

«Дисбаланс, который создает ИИ – защищая руководителей от автоматизации, в то время как работники низшего звена сталкиваются с увольнением – отражает более глубокую структурную проблему», – пишут г-н Сэм Ахмед, управляющий директор технологического стартапа Swarm AI, и д-р Сунгджонг Ро, доцент кафедры управления коммуникациями Сингапурского университета менеджмента, в комментарии для ST.

«Стратегические решения по развертыванию ИИ концентрируются на самом верху и часто принимаются без ответственности за их долгосрочные социальные последствия».

Еще одна проблема, вызывающая беспокойство, заключается в том, что последние достижения в области искусственного интеллекта привели к тому, что созданные искусственным интеллектом творения все более органично вписываются в повседневную жизнь, не привлекая внимания.

Появление инструментов для создания фотографий и видео с использованием искусственного интеллекта, таких как Sora от OpenAI и Nano Banana от Google, привело к тому, что ленты социальных сетей наводнены контентом, который многие пользователи даже не подозревают, что он вообще создан искусственным интеллектом.

Искажение реальности ИИ создало мир

все более убедительные мошенничества

и дезинформация, которая находит огромную аудиторию в социальных сетях.

Доктор Кокил отмечает, что риск заключается не в «внезапном моменте, когда изображения ИИ станут неотличимы от реальности», а в постепенном размывании границы между реальным и нереальным.

Рост количества изображений, генерируемых искусственным интеллектом, означает что сигналы, на которые люди когда-то полагались, чтобы определить подлинность произведения содержания становятся все более бессмысленными.

Это влечет за собой два ключевых последствия. Во-первых, дезинформация, генерируемая ИИ, не обязательно должна вводить в заблуждение. Это также может незаметно укрепить существующие убеждения и предубеждения в среде, где правда имеет меньшее значение.

Во-вторых, ответственность за проверку того, что реально, а что нет, все чаще ложится на отдельных лиц, поскольку институциональные гарантии отстают от достижений в области ИИ.

Полиция Сингапура, Валютное управление Сингапура и Агентство кибербезопасности Сингапура в марте 2025 года выпустили совместную рекомендацию, предупреждающую общественность об использовании мошенничества, связанного с цифровыми манипуляциями, в которых дипфейки ИИ используются для выдачи себя за других.

Совсем недавно, в ноябре 2025 года, The Straits Times обнаружила множество недостоверных аккаунтов, действующих в социальной сети Threads. Эти учетные записи используют изображения, созданные искусственным интеллектом, чтобы вовлечь реальных пользователей в беседу с ними, часто оставляя сотни комментариев к каждому сообщению.

Посты, маскирующиеся под привлекательных женщин и мужчин, несут явные признаки «мошенничества с забоем свиней», когда мошенники завоевывают доверие своих жертв, прежде чем получить деньги с помощью мошеннических инвестиций или криптовалюты.

«Мошенничество с забоем свиней», часто встречающееся в социальных сетях и приложениях для знакомств, со временем заставляет жертв присылать деньги.

ФОТО: СКРИНГРАБ ИЗ ТРЕДА

Такой недостоверный материал переплелся с бизнес-моделью Meta, компании, которая управляет Threads.

По данным расследования Reuters, опубликованного в ноябре 2025 года, компания, занимающаяся социальными сетями, прогнозирует, что около 10 процентов ее общего годового дохода в 2024 году (в размере 16 миллиардов долларов США или 20,5 миллиардов сингапурских долларов) будет приходиться на рекламу мошенничества и запрещенных товаров.

Внутреннее исследование компании, проведенное в мае 2025 года, также показало, что платформы Meta были задействованы в трети всех успешных мошенничеств в США.

Meta не ответила на запрос о комментариях по поводу недостоверных материалов о разделке свиней, которые ST нашла на своих платформах. Однако после публикации истории представитель компании по связям с общественностью, нанятой компанией, поставил под сомнение ссылку в отчете ST на расследование Reuters.

Что касается недостоверного контента, созданного ИИ, то там было лишь радиомолчание.

Эксперты говорят, что перспективы развития ИИ в 2026 году сложны.

Г-н Пун говорит, что «мы одновременно находимся в пузыре и не в пузыре», имея в виду растущие комментарии экспертов о том, похож ли нынешний бум искусственного интеллекта на пузырь доткомов конца 1990-х годов.

«В тех случаях, когда результаты реальны, польза реальна», — отмечает он. «Но в тех случаях, когда много разговоров и завышенных ожиданий, именно там и назревает пузырь».

По словам доктора Кокила, большая часть шумихи вокруг ИИ связана с тем, что он производит результаты, которые выглядят компетентными, даже если ему не хватает обоснования, точности или подотчетности.

Если ИИ приведет к устойчивому улучшению качества решений, обучения или институционального потенциала, то выигрыш будет реальным, добавляет она.

Однако если он в основном производит больше контента – то есть менее разнообразного – одновременно создавая больше работы, затрачиваемой на проверку результатов работы машины, продолжает она: это составляет «перераспределение когнитивного труда, а не революция производительности».

комментарии